无效的输入。不支持特殊字符。

关于 AI 这个流行词汇,人们通常会联想到需要使用强大的计算平台来支持数据中心和大语言模型 (LLM)。在数据中心层面,GPU 在实现 AI(训练)的规模化扩展中发挥了关键作用;而在功耗受限的环境(例如物联网设备、视频监控摄像头和端侧计算系统),部署 AI 则需要采用不同的方法。目前业界正在转向更高效的计算架构,以及专为分布式低功耗应用量身定制的 AI 模型。

我们现在需要重新思考数百万乃至数十亿台终端设备的发展方向,让它们不再是需要连接到云端才能执行 AI 任务的设备。这些设备必须成为真正具备 AI 能力的端侧系统,能够以更高效率执行端侧推理,其计算能力以每瓦特所能达到的万亿次运算次数 (TOPS/W) 来衡量。

实时 AI 计算面临的挑战

随着 AI 基础模型规模迅速扩大,相关基础设施和能耗成本也急剧上升。这使得人们日益关注数据中心的能力,以满足生成式 AI 日益增长的需求。不过,说到端侧实时推理,人们仍然强烈推动在更靠近数据产生的地方(也即设备端)实现 AI 加速。

在端侧管理 AI 带来了新的挑战。现在的问题不再仅限于算力(需要拥有以 TOPS/每秒万亿次运算为单位的充足原始算力),还需要考虑内存性能,同时严格限制每个用例的能耗和成本。这些限制凸显了一个越来越清晰的现实:在任何高效 AI 端侧解决方案中,计算和内存都正在成为同等关键的组成部分。

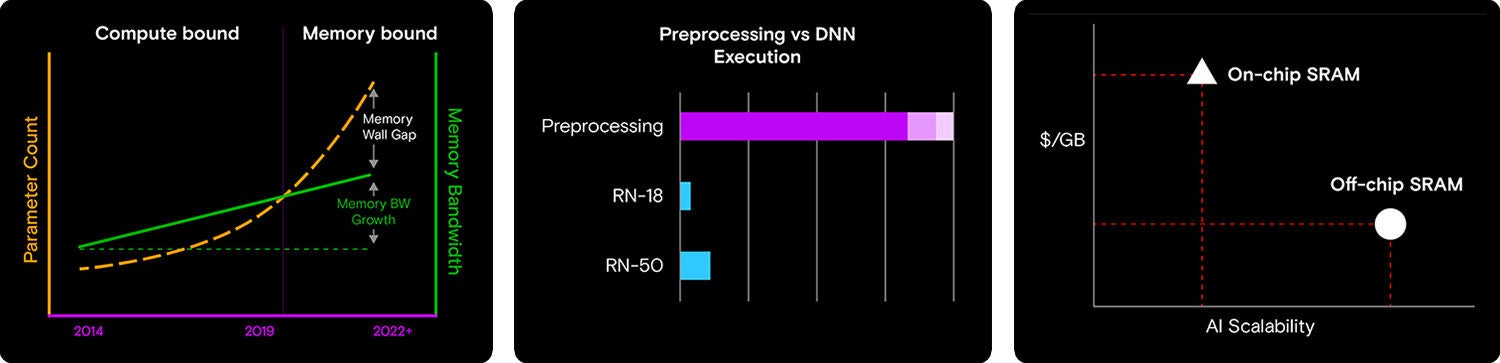

随着 AI 模型日益复杂,能够处理更多输入和任务,其规模和复杂性随之增长,对计算能力的需求也显著提升。TPU 和 GPU 能做到与 AI 需求同步发展,而内存带宽和性能却未能同步提升。这造成了内存瓶颈:GPU 能处理更多数据,但为 GPU 提供数据的内存系统却无法跟上需求。这是一个日益严峻的挑战,凸显了在 AI 系统设计中同步提升计算和内存性能的必要性。

嵌入式 AI 突显了内存的重要性。

生成式 AI 正越来越多地进入工业计算领域。

随着 AI 模型日益复杂、计算能力不断提升,内存带宽仍然是嵌入式端侧 AI 系统的瓶颈,限制了整体性能。

另一个重要考虑因素是:推理涉及一系列数据处理流程,神经网络 (NN) 必须接收经过预处理和筛选的数据。同样地,一旦量化和激活通过 NN,后处理在整个 AI 流程中也变得同样重要。这就像造一辆搭载 500 马力发动机的汽车,却使用了低辛烷值汽油,以及性能不佳的轮胎。无论发动机多么强劲,汽车的整体性能都会受到系统中性能最差部件的限制。

第三个考虑因素是,即便 SoC 集成了 NPU 和加速器功能,作为其沙盒环境的一部分附带一些小容量 RAM 缓存,这些多域处理器仍会增加物料清单 (BOM) 成本,并限制其灵活性。

经过优化的专用 ASIC 加速器价值不可估量。这些加速器不仅能够提高神经网络的效率,还可以灵活支持各种 AI 模型。ASIC 加速器的另一大优势是,优化后的加速器可提供出色的 TOPS/W、更低的功耗和散热要求,非常适合各种端侧应用,如自主农场设备、视频监控摄像头,以及仓库中的自主移动机器人。

计算与内存协同

与端侧平台集成的协处理器能够以低功耗执行实时深度学习推理任务,具备高性价比。这些协处理器可支持多种神经网络、视觉转换器模型和 LLM。

Hailo 的端侧 AI 加速处理器与美光的低功耗 DDR (LPDDR) 内存相结合,是计算与内存协同的经典范例p。两者的结合构成了一个均衡解决方案,在确保能耗和成本符合预算的同时,实现了计算与内存的合理搭配,是端侧 AI 应用的理想之选。

作为排名前列的内存和存储解决方案提供商,美光的 LPDDR 技术能在功耗不变的前提下提供更高带宽,支持高速数据传输,从而消除实时数据处理中的瓶颈。LPDDR 通常应用于智能手机、笔记本电脑、车载系统和工业设备。它尤其适合嵌入式 AI 应用,这类应用对内存的 I/O 带宽和高速引脚速度有较高要求,以满足现代 AI 加速器的发展需求。

例如,LPDDR4/4X(低功耗 DDR4 DRAM)和 LPDDR5/5X(低功耗 DDR5 DRAM)的性能比前几代产品显著提升。LPDDR4 的每引脚速度高达 4.2 Gbits/s,总线宽度高达 64 位。美光 1-beta LPDDR5X 进一步将性能提升了一倍,每引脚速度高达 9.6 Gbits/s,同时其功耗相比 LPDDR4X 降低了 20%。这些技术进步非常重要,有助于满足端侧 AI 应用日益增长的需求。在这些应用中,速度和能效都是至关重要的因素。

Hailo 是与美光合作的知名 AI 芯片供应商之一。Hailo 的突破性 AI 处理器具有独特的设计,支持在端侧设备上运行高性能深度学习应用。Hailo 处理器专为在端侧运行新一代生成式 AI 应用而研发,结合多种 AI 加速器和视觉处理器,可在端侧实现智能感知和视频增强。

例如,Hailo-10H AI 处理器可提供高达 40 TOPS 的运算能力,是一款可用于无数用例的 AI 端侧处理器。Hailo 表示,Hailo-10H 具备独特、强大、可扩展的结构驱动数据流架构,充分利用了神经网络的核心特性。该处理器使端侧设备能够全面运行深度学习应用,比传统解决方案更高效,同时能够大幅降低成本。

实施解决方案

AI 视觉处理器是智能相机的理想选择。Hailo-15 VPU 片上系统 (SoC) 将 Hailo 的 AI 推理能力与先进的计算机视觉引擎相结合,可生成优质图像,并提供高级视频分析功能。其视觉处理单元的 AI 能力可用于 AI 驱动的图像增强,以及全面高效地处理多个复杂的深度学习 AI 应用。

美光的低功耗 DRAM (LPDDR4X) 已针对广泛应用经过严格测试,搭配 Hailo 的 AI 处理器后,能够满足多样化应用需求。从工业和汽车应用的严苛温度和性能需求,到企业系统严格要求的规格,美光 LPDDR4X 是 Hailo VPU 的理想伴侣,能够在功耗不变的前提下,提供高性能、高带宽的数据传输。

合作共赢

随着越来越多的用例采用支持 AI 的设备,开发人员需要重新考虑数百万台甚至数十亿台终端设备的未来定位,使其不仅仅充当云端计算的代理,而是成为真正具备本地 AI 推理能力的端侧设备,能够以较低的 TOPS/W 实现本地推理。借助专为加速端侧 AI 落地而设计的全新处理器,以及安全可靠、低功耗且高性能的 LPDRAM,端侧 AI 将能够支持越来越多的应用场景。